大语言模型的本地部署分享

大语言模型的本地部署分享

前几天用的梯子过期没续费,直接用不了chatgpt,差点耽误我交作业,因此我想本地部署一个大语言模型,满足我的使用需求

目标

能够成功在本地部署大语言模型,实现不通过联网使用的目的。

流程

下载

ollama

用魔法进入ollama官网 https://ollama.com/ 下载ollama启动器,并完成安装。

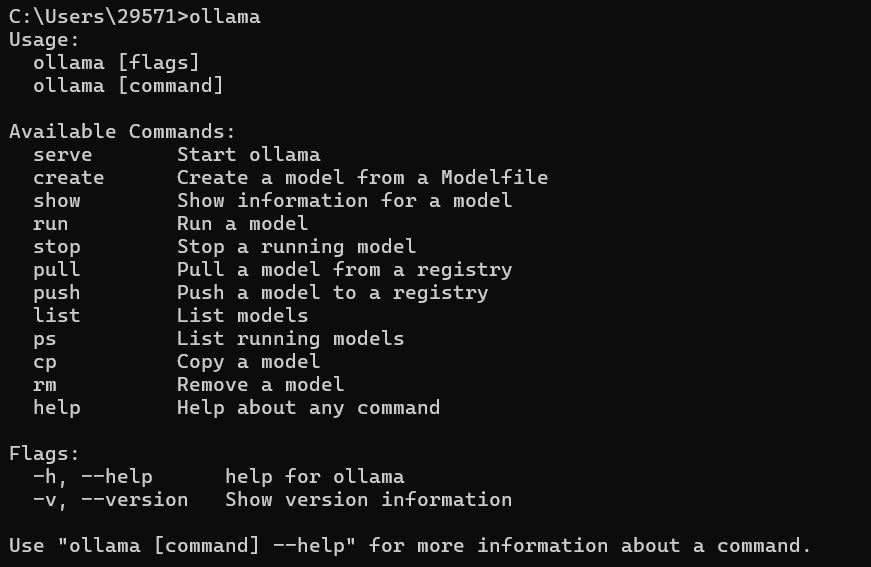

进入cmd,输入ollama来判断是否安装成功。

通过

ollama下载大语言模型

进入官网下载大语言模型,由于是个人电脑,推荐选小一点的。比如9b,就是9亿参数,大概五个g。

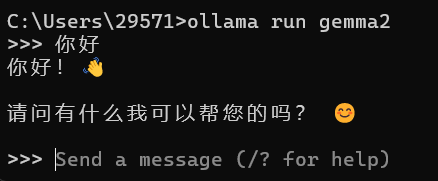

下载完成后我们可以通过命令行调用的方式完成对话,先输入ollama run gemma2,然后对话即可。

下载

docker,下载openwebui并且部署

既然已经可以运行,我们为什么还要下载docker和openwebui呢?因为输入命令行调用的方法太过繁琐,而docker和openwebui能给我们一个整洁的页面,前者可以理解为一个后端,而后者可以理解为前端页面。首先我们进入

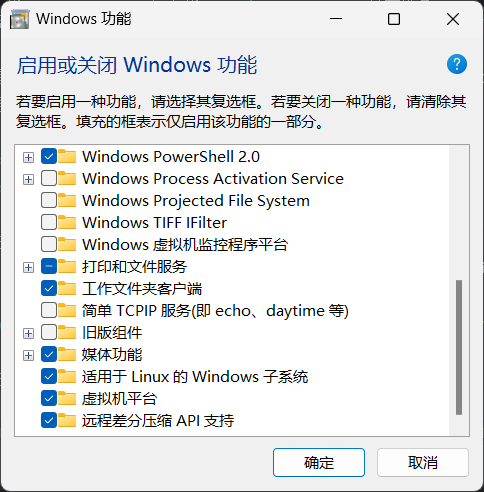

docker下载地址https://github.com/tech-shrimp/docker_installer 在浏览器内打开,我们需要在本地启用或关闭windows功能中选择适用于linux的windows子系统和虚拟机平台,打勾,重启电脑。

再通过管理员权限打开cmd,复制以下代码并运行:1

2wsl --set-default-version 2

wsl --update --web-download

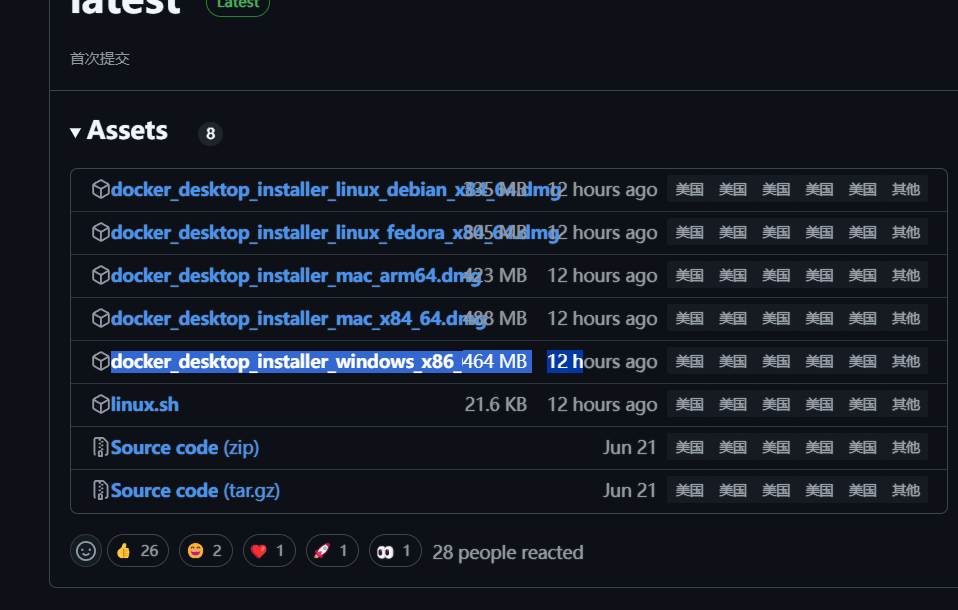

安装完成后进入页面右侧release下载 docker_desktop_installer_windows_x86_64.exe并且双击下载完成的

docker启动器完成docker安装。

之后下载openwebui,进入网址 https://github.com/open-webui/open-webui ,在docker开启的条件下在cmd中运行以下命令1

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

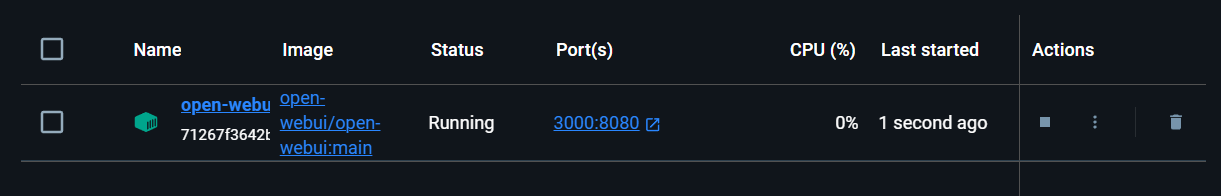

安装完成后在

docker中就能找到端口号进行访问。